Ist es nicht erstaunlich mit welchem Druck das Thema „Künstliche Intelligenz“ (KI) seit Monaten durch die internationalen Medien gedrückt wird?

Überwiegend mit positiven, ja sogar begeisterten Kommentaren.

Sicher, hier und da wird auf „Ungenauigkeiten der KI“ hingewiesen oder flapsig von „KI-Flunkern“ (Hendrik Wieduwilt im Artikel „Das KI-Flunkern von ChatGPT wird zur Haftungsfalle vom 2. Mai 2024 in FAZ+, Paywall) gesprochen bzw. geschrieben. Aber Tenor ist doch fast immer: OK, so was kann ja mal bei einer neuen Technologie passieren. Stimmt.

Aber geschenkt. Bananensoftware reifte schon immer beim Kunden.

Denkt denn kaum jemand dieses „KI-Flunkern“ mal zu Ende?

Viel zu selten kann man kluge kritische Beiträge dazu lesen, wie zum Beispiel „Das Ende des Internets, wie wir es kennen“ von Kira Kramer, FAZ+ vom 30. März 2024, Paywall.

Zunächst eine notwendige Eingrenzung des Schlagwortes „Künstliche Intelligenz“ für diesen, am Ende dann doch auch persönlich werdenden Beitrag:

Hier geht es im folgenden nur um textbasierte KI deren Wissensbasis mithilfe von automatisierten Trainings und Milliarden (!) von Internet Inhalten maschinell generiert wurde. So ganz genau beschreibt natürlich kein Anbieter, wie das jeweilige Training abläuft. Wenn aber die NEW YORK TIMES Klage gegen CHATGPT einreicht, weil deren KI ganz offensichtlich dreist mit den Inhalten der kommerziellen Nachrichtenprofis trainiert wurde, dann wird wohl jedem das erstaunlich einfache technische Prinzip von „Künstlicher Intelligenz“ klar:

Um eine menschliche Frage zu beantworten, fragt die KI einfach mal „das Internet“, am Besten parallel verschiedene Quellen, vermengt das gefundene anhand zuvor festgelegter Satzmuster zu einer „eigenen“ Antwort damit man unter anderem aus der Urheberrechtsproblematik heraus kommt und fertig ist die verblüffende Antwort der Maschine.

Nichts anderes machen wir Menschen ja auch:

Wenn man beispielsweise wissen wollte wie man seine defekte Waschmaschine selbst reparieren kann, dann googelt man den Fehlercode und findet schon mal die Ursache heraus. Dann googelt man nach Fehlerbeseitigung, findet in der Regel Text und Videobeiträge zur Reparatur und Ersatzteilnummern. Verteiltes Netzwissen kondensiert im Hirn des Hobbyschraubers.

Nun würde so eine maschinelle „intelligente“ Internetsuche in Echtzeit viel zu lange dauern. Außerdem wäre die Wissensbasis äußerst volatil – Inhalte im Internet ändern sich ständig.

Seit Anbeginn des Computerzeitalters versuchen Heerscharen von Softwerkern seit mit einer zuvor erstellten „Wissensbasis“ (oder „Wissensdatenbank“, neudeutsch „Knowledge Base“) ihre Software „schlau“ (oder gar „intelligent“) zu machen.

Unvergessen die Programmiersprache PROLOG Anfang der 1970iger Jahre.

Aus heutiger Sicht eher schon putzig kam ELIZA ein paar Jahre zuvor daher, welch´ ambitionierter Softwareentwickler hat nicht fasziniert mit den (damaligen) technischen Möglichkeiten davon geträumt, das die eigene ELIZA Implementation den TURING-TEST bestehen konnte?

Das Erstellen einer relevanten Wissensbasis war jahrzehntelang sehr aufwendig und auch kompliziert. Neben dem initialen Aufbau durch kluge Menschenhirne ist für lange Zeit ein ebenfalls durch fachkundige (in Bezug auf das zu hinterlegende Wissen) Menschen durchgeführtes permanentes Training notwendig, um eine wirklich seröse Qualitätsstufe der von der Maschine gegebenen Antworten zu erreichen.

Wissensbasen werden im übrigen nicht von Softwareentwicklern erstellt, sondern von Knowledge Base Designern, die das Wissen der Fachleute in das jeweilige Sprachmodell übertragen.

Irgendwann kam „das Internet“ als technisches Datennetzwerk für die elektronische Kommunikation. Aber erst das darauf aufbauende WORLD WIDE WEB ermöglichte eine breite Wissensvermittlung über elektronische Wege. Genau dafür und vor allem nur dafür hat es TIM BERNERS-LEE schließlich entwickelt!

Doch das WORLD WIDE WEB, so wie es ursprünglich mal gedacht war, stirbt durch monolithische Plattformen und absurde Monetarisierung durch Werbung seit vielen Jahren einen elend langen Tot. Allerdings erscheint vielen das mittlerweile darin angesammelte Wissen vordergründig schier unermesslich groß.

Was lag & liegt also näher, als „das Internet“ als Quelle für eine maschinell erzeugte Wissensbasis heran zu ziehen? Nur eine Frage von genügend Datenleitungen, Rechenzentren und Speicher. Brute Force as its best.

Nun, vielleicht die Tatsache das in diesem unserem Internet mittlerweile garantiert mehr Schwachsinn als seriöses Wissen gespeichert ist und es niemanden (im übrigen auch keine KI) gibt, der die Spreu am Weizen trennen kann. Oder die Tatsache das es sich bei diesen automatisierten Trainings schlicht um Datendiebstahl handelt?

Sicher, man könnte anfangen einzelne WORLD WIDE WEB Teilnehmer wie zum Beispiel die NEW YORK TIMES als „seriös“, „glaubwürdig“ und „wissend“ zu klassifizieren und deren Wissen in der maschinell erstellten Wissensbasis entsprechend als glaubwürdiger zu behandeln. Aber alle Internetseiten der Welt so zu kategorisieren wäre sicher eine unglaublich große Aufgabe und Menschen wie zum Beispiel Herr TRUMP hätten im Einzelfall sicher eine andere Einschätzung und Lizenzverhandlungen mit Millionen von Anbietern würden nie enden.

Wer also kann echtes „Wissen“ verantworten?

Wer also kann wirklich relevanten Wissensbasen für KI Systeme erstellen?

Menschen, Menschen, Menschen.

Wissende Menschen, in ihren Fachbereichen anerkannte Persönlichkeiten, die mit ihrem Lebenswerk die Wahrhaftigkeit ihres Wissens bereits dokumentiert haben.

So lange KI Sprachmodelle maschinell mit den vermüllten Inhalten des WORLD WIDE WEB gefüttert werden, braucht man sich wohl nicht damit ernsthaft zu befassen. Es ist ganz einfach: Müll rein, Müll raus. War in der maschinellen Datenverarbeitung im übrigen schon immer so. Denn, das mag für manche nun schmerzhaft sein, ein Computer ist nicht intelligent.

Allerdings, und das wird nun wirklich zu einem Problem:

Einfach ignorieren kann man den KI-Hype dieser Tage leider auch nicht. Nach dem das WORLD WIDE WEB jahrelang von wenig begabten Schreiberlingen mit leicht zu erkennenden Textmüll zu angesagten Themen geflutet wurde, ausschließlich um auf diesen Seiten Werbeplätze verkaufen zu können, werden solche absolut überflüssigen Internetseiten nun maschinell, durch Software, eben durch KI erzeugt.

Heraus kommen gut lesbare Texte die ohne weiteres, tiefer gehendes Wissen absolut glaubwürdig erscheinen.

Ein reales persönliches Beispiel:

GOOGLE Suche nach „Wiedekamm“

„Peter Wiedekamm (1908-1995) war ein deutscher Schriftsteller und Journalist. Er hat zahlreiche Ratgeber und biographische Bücher veröffentlicht. Unter anderem gibt es sein Werk „Die große Phantasie“ aus dem Jahr 1960.“

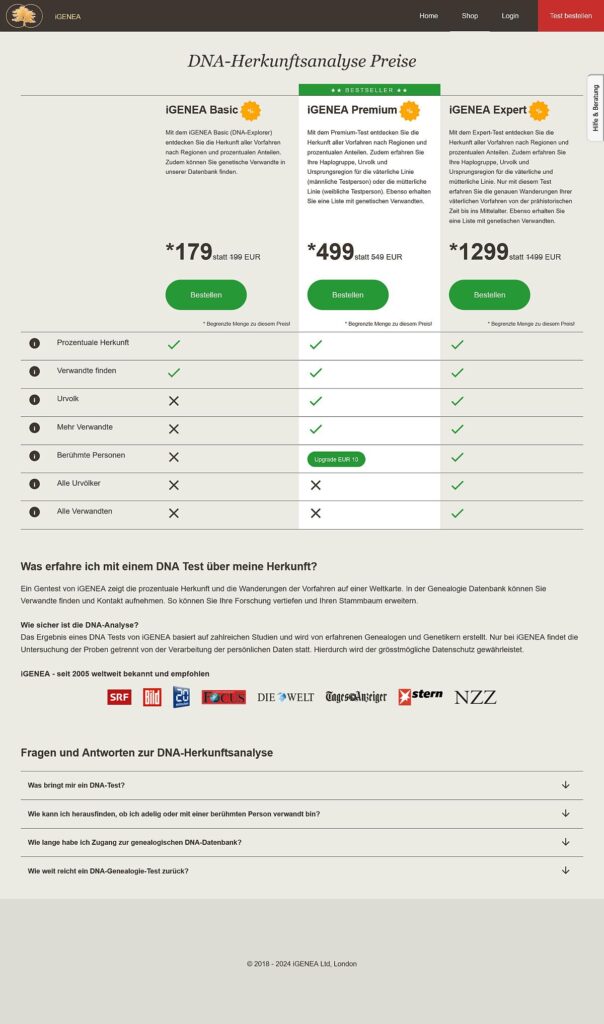

Zitat der Website „iGENA“, abgerufen am 3. Mai 2024, 14:00 Uhr

„Die Inhalte unseres Internetauftritts wurden unter Einbezug künstlicher Intelligenz erstellt. Für die Richtigkeit, Vollständigkeit und Aktualität der Inhalte können wir keine Gewähr übernehmen.“

Zitat der Website „iGENA“, abgerufen am 3. Mai 2024, 14:01 Uhr

Also das ist doch jetzt mal echt (Entschuldigung!) geil!

Es gab & gibt tatsächlich nur einen, wirklich nur den einen wahren PETER WIEDEKAMM.

Kann man jetzt glauben oder auch nicht, allerdings hat der Urheber dieses Textes einen Personalausweis in dem genau dieser Name auftaucht und er kennt ALLE WIEDEKAMM´s in Deutschland persönlich.

In unserem Land gab es nie einen anderen PETER WIEDEKAMM. Wenn nicht noch ein paar männliche Enkel das Licht der Welt erblicken und einer davon auf eben jenen Vornamen getauft wird, wird es wohl auch zukünftig keinen anderen PETER WIEDEKAMM geben.

Dieses leicht nachprüfbare Wissen kann der Autor auf Wunsch mit eigenem Blut unterschreiben.

KI generierter Schwachsinnstext nur um irgendwelche zwielichtige super teure DNA Herkunftstests zu verkaufen? Während der Schreiberling mühevoll seit Jahrzehnten (!) seine ureigene WORD WIDE WEB Seite befüllt und betreibt, kommen nzn windige Geschäftemacher mit „moderner“ Technik um die Ecke, verbreiten leicht zu glaubende Fake-News und landen damit ohne Probleme in der GOOGLE Suche auf Rang 7 der Seite 1.

Das spätestens ist nun endgültig die untergehende Internet Abendsonne!

Nichts, aber wirklich gar nichts ist an dem so gefällig zu lesenden „iGENA“ „Beitrag“ richtig:

1) Der Nachname WIEDEKAMM stammt aus DÄNEMARK. Der Schwiegervater war dänischer Seemann, blieb in BREMEN hängen, gründete eine Familie und importierte so den in DÄNEMARK weit verbreiteten Namen exklusiv nach DEUTSCHLAND.

2) Alle WIEDEKÄMMER in DEUTSCHLAND stammen von diesem einen Seemann ab, sind untereinander bekannt und sehen sich in der Regel wenigstens einmal im Jahr.

3) Die Menschen Stefan, Friederike, Alfred, Johannes, Agnes, Friedrich, Julius und Helene Wiedekamm gab & gibt es nicht (Stand 2024).

4) Christa gab es, aber anderer Beruf, anderes Geburts- und Sterbejahr.

5) Peter ist nicht tot, wäre zwar gerne ein besserer Schreiberling, war aber Seemann und danach eine lange Zeit leidenschaftlicher Softwerker.

Muss man ab jetzt ernsthaft KI generierten Schwachsinn über einen selbst finden und richtig stellen?

Oder sollte man Unternehmen, die mit solch groben Schwachsinn das Internet fluten um damit Geschäfte zu machen schlicht reihenweise verklagen? Reichen mögliche hohe Geldstrafen zur Abschreckung? Mindestens zweifelhaft, denn es sind Maschinen, die diese Texte autonom erstellen.

Die Organisation „NOYB – Europäisches Zentrum für digitale Rechte“ aus WIEN beschreitet gerade diesen Rechtsweg. Das wird sich wohl schnell zu einem sehr langen Kampf gegen sehr, sehr viele Windmühlen entwickeln?

Seit Monaten lungert in diesem Blog ein nicht veröffentlichter Kommentar auf meinen Beitrag „Fotobuch: WHITEWALL vs. CEWE“ herum. Der folgende Text ist so schwachsinnig, einfach unmöglich das diese Sätze von einem Menschen stammt. Vermutlich hat irgendeine Software den vorhandenen Beitragstext durch ein paar Zeilen Programmcode gequetscht und das äußerst dumme Ergebnis automatisch gepostet:

Natürlich handelt es sich nicht um einen ernsthaften Kommentar zu dem Beitrag, sondern nur um miese, recht perfide Linkwerbung: Durch Angabe der URL ihrer eigenen, kommerziellen Homepage erhoffen einige ganz schlaue, Linkrelevanz bei GOOGLE zu erzeugen. Kostenlos, selbstverständlich. Doch das ist ein anderes Thema.

Manchmal, in letzter Zeit allerdings durchaus öfter, fragt man sich als einer, der „dem Internet“ eigentlich alles zu verdanken hat, was man da bloß angefangen hat?

Und vor allem:

Wie kann man das stoppen?

Peter.

Moin,

interessante Erkenntnisse… während „KI“ (also Sprachmodelle) in meiner täglichen Arbeit mit Softwarecode ganz wunderbar Routinearbeit abnehmen, ist das, was du hier schilderst, äußerst unschön.

Es ist wie mit jedem vom Menschen gemachten Werkzeug: Kann sinnvoll verwendet werden, kann und wird aber auch missbraucht. Leider bietet „KI“ unfassbar viel Potential für Missbrauch in Dimensionen, die sich so gut wie alle Menschen in der Welt nicht vorstellen können.

Aber die Technik ist da, und sie wird nicht verschwinden. Und wie es ausgeht weiß niemand.

Ahoi Julian!

Stimmt schon, es kommt darauf an, was man mit neuer Technologie macht.

Ich glaube ja gar nicht, das ein Mensch bei „iGENA“ gezielt einen Text für „Wiedekamm“ mit KI generiert hat, sondern das vollkommen automatisiert nach Familiennamen gesucht wird (Adressdatenbanken, Google Trends, Domainsuche), die dann in die KI gekippt werden, ein gut zu lesender Text heraus kommt und der dann ohne jede Überprüfung ebenfalls automatisiert im Internet publiziert wird.

Im Internet dieser Zeit geht es eigentlich nur noch um Werbung & Verkaufen. Dafür ist eine sehr gute Sichtbarkeit in den Suchmaschinen zwingend notwendig. Das setzt wiederum voraus, das es möglichst viele Internetseiten gibt die mit guten Textinhalten ein Thema behandeln und vielleicht sogar Produktempfehlungen aussprechen.

Bisher war das Verbreitungsregulativ der durch Menschen zu erbringende Aufwand in der Erstellung von solchen Internetseiten. Mit KI kann jetzt in Stunden das Internet mit speziellen Seiten zu speziellen Themen vollkommen automatisch geflutet werden.

Bei Verkaufsgetriebenen Internetseiten beurteilt vielleicht noch ein Mensch redaktionell das Ergebnis, denn es würde wohl problematisch werden, wenn falsche Angaben gemacht würden. Allerdings verkaufen diese Vermittlungsseiten ja nicht selbst sondern leiten nur auf AMAZON & Co. weiter und kommen so aus jeder Haftung raus.

Während bei der Softwareentwicklung, in Unternehmen oder in Behörden das jeweils benötige Fachwissen in die jeweilige KI einfließen wird, weil ansonsten die Ergebnisse zu beliebig werden, ist die gerade gehypte allgemeine KI offenbar völlig beliebig.

Deren Fehler, Flunkern oder Ungenauigkeiten fallen nur im Einzelfall auf wenn sich jemand mit einem speziellen Inhalt oder Thema befasst. Änderbar sind die falschen Ergebnisse angeblich nicht, also bleiben sie erst mal so im Internet stehen. Und irgendwann durchpflügt die nächste KI Trainingswelle das Internet und die falschen Inhalten finden Eingang in „neues Wissen“.

Katastrophal.

Die großen Kamerahersteller (NIKON, CANON & Co.) arbeiten derzeit an einem Verfahren, um Fotos die mit ihren Geräten aufgenommen wurden, fälschungssicher als authentisch fotografiert zu markieren. Damit will man echte Fotos von denen, die mit KI generiert wurden, abgrenzen.

Mag sein, das so ein Verfahren eine Zeit lang sicher wäre, aber die Geschichte von Kopierschutzsystemen (für Software, Musik oder Filme) hat ja gezeigt, das solche Verfahren immer irgendwann ausgehebelt werden.

Für Texte im Internet ist das aber wohl absolut unmöglich?

Peter.